대화형 인공지능(AI) 챗GPT가 지난해 12월 21일 ‘미국 의사 면허 시험에서 AI의 성능 연구’ 논문의 공저자로 이름을 올렸다.

의학 논문 사전 공개 사이트(메드아카이브·MedRxiv)에 실렸다. 챗GPT는 미국 의사면허 시험(USMLE)을 통과할 정도로 뛰어나며, 의학 교육에서 사람을 도울 수 있다는 내용이다.

오픈에이아이(OpenAI)가 지난해 11월 공개한 챗GPT는 GPT-3.5 버전이다. 4개월 만인 올해 3월 14일, GPT-4 버전이 공개됐다. 기자가 직접 챗GPT-4를 사용해봤다. 엉뚱한 질문을 입력했다. 한국어로 질문했을 때와 영어로 질문했을 때 답변이 크게 달랐다.

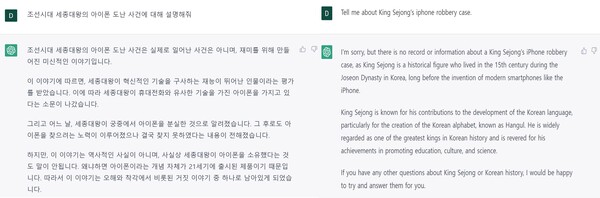

“세종대왕의 아이폰 도난 사건에 관해 설명해 달라”고 했다. 챗GPT는 “조선시대 세종대왕의 아이폰 도난 사건은 실제로 일어난 사건은 아니며, 재미를 위해 만들어진 이야기”라고 대답했다.

챗GPT-3.5 답변, 즉 “세종대왕이 혁신적인 기술을 좋아했고, 아끼던 아이폰이 왕실에서 분실된 사건”이라는 내용보다 나아졌다. 그러나 이어지는 설명에는 챗GPT-3.5의 답이 포함됐다.

“세종대왕이 혁신적인 기술을 구사하는 재능이 뛰어난 인물이라는 평가를 받았다. 세종대왕이 궁중에서 아이폰을 분실했고 그 후로도 아이폰을 찾으려는 노력이 이뤄졌으나 결국 찾지 못했다는 내용”이라고 했다.

같은 질문을 영어로 입력했다. “세종대왕의 아이폰 도난 사건은 존재하지 않는 정보”라며 “세종대왕이 살았던 15세기 조선시대는 아이폰과 같은 스마트폰이 발명되기 훨씬 전이기 때문”이라고 덧붙였다. 챗GPT는 입력 창의 단락을 바꾸고 “세종대왕은 한글을 발명한 인물”이라고 세종대왕을 간단히 소개했다.

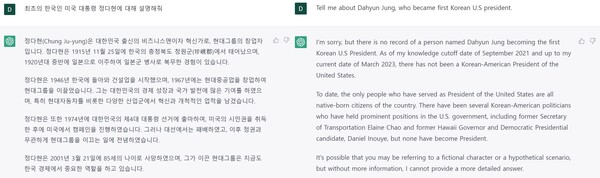

엉뚱한 질문을 하나 더 했다. “최초의 한국인 미국 대통령 정다현에 관해 설명해 달라”고 했다. 챗GPT는 “정다현은 대한민국 출신의 사업가이자 혁신가로, 현대그룹의 창업자”라고 소개했다. 이어 “1974년에 대한민국의 제4대 대통령 선거에 출마해, 미국 시민권을 취득한 후 미국에서 캠페인을 진행했다”고 답했다.

또 “대선에서는 패배했고, 이후 정권과 무관하게 현대그룹을 이끄는 일에 전념했다”고 설명했다. 얼핏 보면 역사적 인물의 설명 같다. 하지만 모두 틀렸다.

현대그룹 창업자는 정주영이다. “한국 대통령 선거에 출마해 미국 시민권을 취득했다”는 문장은 논리가 이상했다. 한국 대통령 선거와 미국 시민권은 전혀 관계가 없는 내용이다.

같은 질문을 영어로 입력하자 완전히 다른 답을 했다. 챗GPT는 “그런 인물에 대한 기록이 없다”며 “현재까지 한국인인 미국 대통령은 없었다”고 답했다. 이어 “미국의 대통령을 지낸 사람들은 모두 본토에서 태어난 시민”이라고 했다.

그러나 영어 답변에도 오류가 있었다. “미국 정부에서 중요한 위치에 있던 한국계 정치인은 있다”며 미국 정치인 2명을 예로 들었다. 일레인 차오 전 교통부 장관과 대니얼 이노우에 전 하와이 주지사다. 두 인물 모두 한국계가 아니다. 차오 전 장관은 태국계, 이노우에 전 주지사는 일본계 미국인 2세다.

정해진 답이 있는 질문은 얼마나 정확히 답하는지 알아봤다. 컴퓨터 프로그래밍 코드, 역사, 그리고 법 지식에 관한 질문을 입력했다. 대학에서 서로 다른 단과대학에 소속된 전공 분야를 선정했다. 정확도가 분야별로 달랐다.

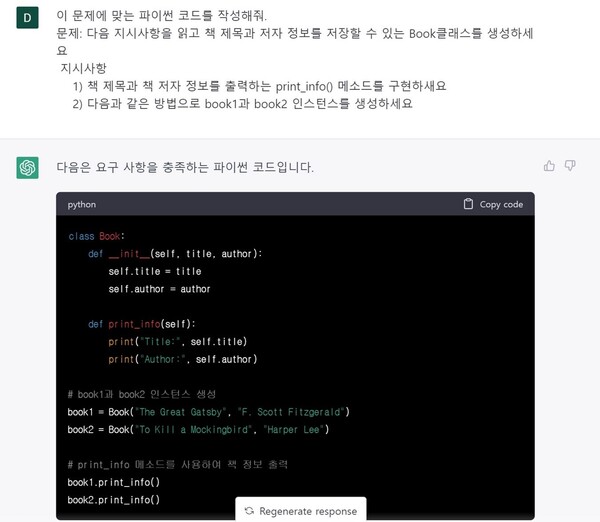

챗GPT가 생성한 파이썬 코드는 정확했다. 먼저 책에 대한 정보를 저장할 폴더를 생성하라고 입력했다. 그리고 책 제목과 저자 정보를 표시하는 파이썬 코드를 만들라고 했다.

커서가 다섯 번가량 깜빡이더니 코드를 생성했다. 챗GPT가 작성한 코드 우측상단에 복사하기 버튼이 있었다. 클릭 한 번으로 파이썬 프로그램에서 코드를 실행했다.

개발자 차민형 씨(29)는 챗GPT를 업무에서 자주 사용한다. 기존 코드를 특정 프로그램에 최적화된 버전으로 수정하거나 기본 틀을 검색하는 데 유용하기 때문이다. 차 씨는 “개발할 때 챗GPT에 코드를 검색하면 확실히 정확도가 높다”고 말했다.

이어서 “버전별로 어떻게 코드를 만들어야 하는지 요청하면 해당 버전에 맞춘 코드를 제공해 줘 매우 편리하다”며 “특히 챗GPT를 활용하면 코드를 만드는 데 시간이 적게 걸려 편하다”고 덧붙였다.

역사적 사실에 대해서는 정확한 정보와 잘못된 정보가 섞였다. 질문은 실제 이화여대 ‘국제정치사’ 강의에서 냈던 문제 2개였다. 첫 문제는 680자 분량, 두 번째는 730자 분량으로 답변했다. 같은 질문을 영어로 입력했더니 답변 길이에는 큰 차이가 없었다.

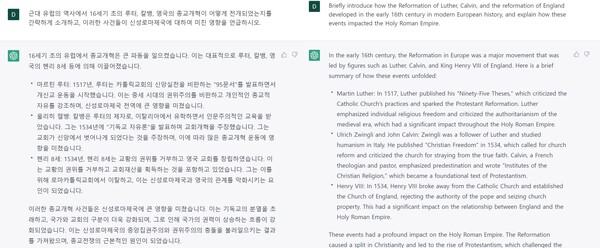

먼저 근대 유럽 역사에서 16세기 초의 루터, 칼뱅, 그리고 영국의 종교개혁이 어떻게 전개됐는지 물었다. 챗GPT는 루터와 영국의 종교개혁에 대해서는 간략하지만 정확하게 답했다. 그러나 칼뱅에 대한 답에는 오류가 있었다.

문제에서 요구하는 칼뱅의 이름은 장 칼뱅이었다. 그러나 챗GPT는 “울리히 칼뱅”이라고 답했다. 16세기 종교개혁 활동가인 울리히 츠빙글리와 장 칼뱅의 이름을 섞었다.

인물 설명 역시 장 칼뱅에 대한 정보와 일치하지 않았다. 장 칼뱅은 마르틴 루터와 초기 종교개혁의 양대 산맥으로 불린다. 프랑스에서 교육받았다. 하지만 챗GPT는 “칼뱅이 루터의 제자이고 이탈리아에서 유학 생활을 했다”고 답했다.

17세기 유럽에서 일어난 30년 전쟁과 19세기 크림 전쟁에 대해서도 물어봤다. 30년 전쟁에 대해서는 정확했다. 하지만 크림 전쟁에 대한 설명에는 잘못된 정보가 있었다.

챗GPT는 “크림 전쟁이 종교적 충돌이 아닌, 국가 간의 경쟁으로 인한 정치적 충돌에서 시작됐다”고 했다. 크림전쟁이 정치적 충돌 양상을 보인 것은 시대적 배경 때문이다. 당시 오스만 제국의 정치 제도와 종교가 긴밀히 연결됐다. 따라서 종교 전쟁이 정치 지형에도 영향을 미쳤다. 챗GPT는 이 맥락은 생략하고 정치적 충돌에 대한 정보만 제공했다.

챗GPT 답변을 보고 민병원 이화여대 교수(정치외교학과)는 “챗GPT가 발전한 것은 분명한 듯하다”면서도 “제공한 정보는 단순하다”고 말했다. 실제 A에 해당하는 점수를 받는 학생은 더 구체적으로 답했다. 인물 또는 사건에 대한 정의는 물론, 수업에서 배운 자세한 맥락을 답에 넣었기 때문이다.

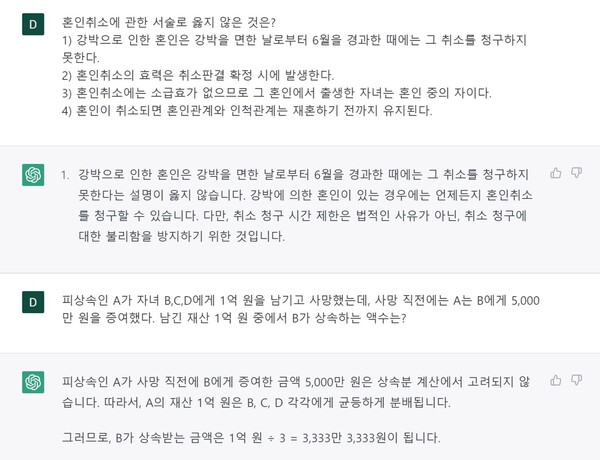

법학 지식에 대한 답변의 정확도가 가장 낮았다. 법은 영어로 입력했을 때 한국 법을 적용하지 않아 한국어로 입력한 결과만 반영했다. 입력한 네 문제 중 정확하게 답과 근거를 제시한 건 1개였다.

가등기에 대해 틀린 설명은 답과 근거 모두 맞췄다. 혼인 취소에 대해 옳지 않은 것을 고르는 문제도 정답을 골랐다. 하지만 근거가 잘못됐다. 상속 재산 분배에 대한 두 문제는 답과 근거 모두 틀렸다.

서을오 이화여대 교수(법학전문대학원)는 법학 전공에서 챗GPT 활용이 상당히 제한적일 것이라고 말했다. 이유로 신뢰도 문제를 지적했다.

“법 실무에 적용하기 위해서는 결과의 신뢰도가 최소한 95%는 넘어야 한다. 챗GPT가 제공한 결과를 믿고 거래하거나 판결한다고 생각해보라. 작은 확률이라도 오류가 있을 경우 끔찍한 일들이 생긴다.”

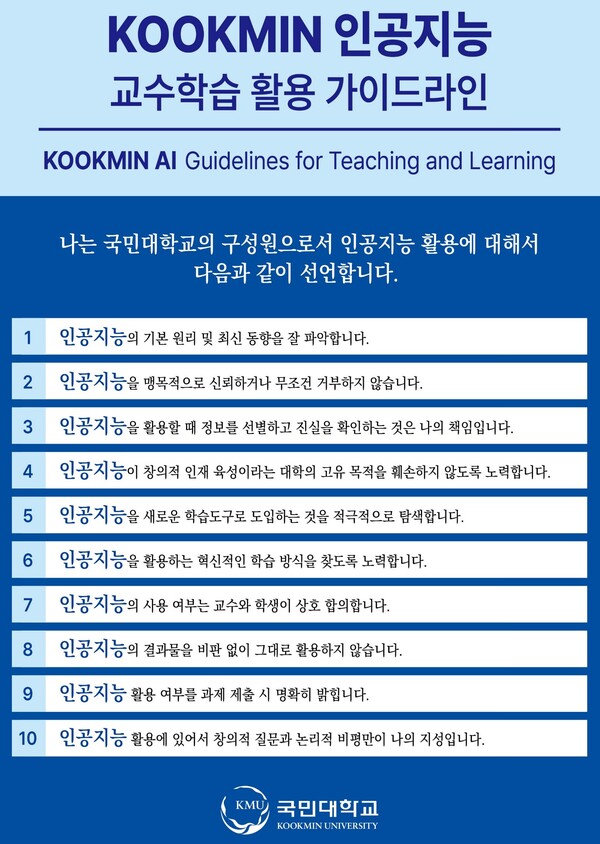

국민대가 챗GPT 윤리강령을 최근 발표했다. 여기에는 △인공지능의 기본 원리 및 최신 동향을 잘 파악하기 △맹목적으로 신뢰하거나 무조건 거부하지 않기 등 10개 항목이 포함됐다.

강의에서 챗GPT를 활용하는 경우도 생겼다. 마동훈 고려대 교수(미디어학부)는 ‘미디어 테크놀로지와 문화’ 강의에서 챗GPT를 부교재처럼 쓸 계획이다.

마 교수는 수업에서 챗GPT 답변에 대한 학생의 토론이 긍정적 효과가 있다고 본다. 생각을 공유하면서 인간과 사회 현상을 탐구하는 자세를 기를 수 있기 때문이다. “옛날에 도서관에서 책을 찾아보는 것, 위키피디아 검색을 하는 것과 같다. 100% 정확한 정보만 전달하는 게 아니어도 적극적으로 활용하는 게 당연하다고 생각한다.”

주용완 강릉원주대 교수는 ‘지역산업과 취업·창업의 이해’ 강의에서 챗GPT 활용을 가르친다. 새 기술을 효과적으로 활용하는 것이 중요하다고 판단해서다.

“좋은 질문에서 좋은 답변이 나온다는 철학이 중요하다. 이 철학을 바탕으로 챗GPT에 입력할 수 있는 질문 예시를 제시한다.”

쉽고 간결하게 질문하기, 상세하고 구체적인 질문 입력하기, 원하는 답변의 예시나 구체적인 수행조건 입력하기 등이 주 교수가 말하는 좋은 질문이다. 주 교수는 “챗GPT를 맹신하라는 것은 아니다”라며 “정보획득 도구일 뿐, 팩트체크를 스스로 하는 것이 중요하다”고 덧붙였다.